Introducción

Imagínese preguntar a su sistema CRM: «¿Puede escribir un correo electrónico a un cliente que tiene problemas para iniciar sesión en su cuenta?» En el mundo actual impulsado por la IA, los Large Language Models (LLM) pueden gestionar este tipo de solicitudes sin esfuerzo, elaborando correos electrónicos, diseñando elementos visuales, absorbiendo información e incluso aventurándose en la codificación. Las expectativas de nuestros sistemas CRM han evolucionado drásticamente, y los LLM son cada vez más versátiles. Pero hay una nueva ola en el horizonte, una que promete aún más autonomía y eficiencia. A diferencia de los LLM, que son fantásticos generando texto y respuestas, los LAM van un paso más allá gestionando de forma proactiva flujos de trabajo completos sin necesidad de instrucciones explícitas para cada tarea. Imagine un sistema CRM que no sólo sabe lo que usted quiere, sino que también se anticipa a sus necesidades, automatizando procesos y tomando decisiones informadas en su nombre. Aquí es donde brillan los LAM, aprovechando sus raíces en campos como la robótica, los vehículos autónomos y la IA de juegos, donde la comprensión del contexto y la toma de decisiones en tiempo real son cruciales.

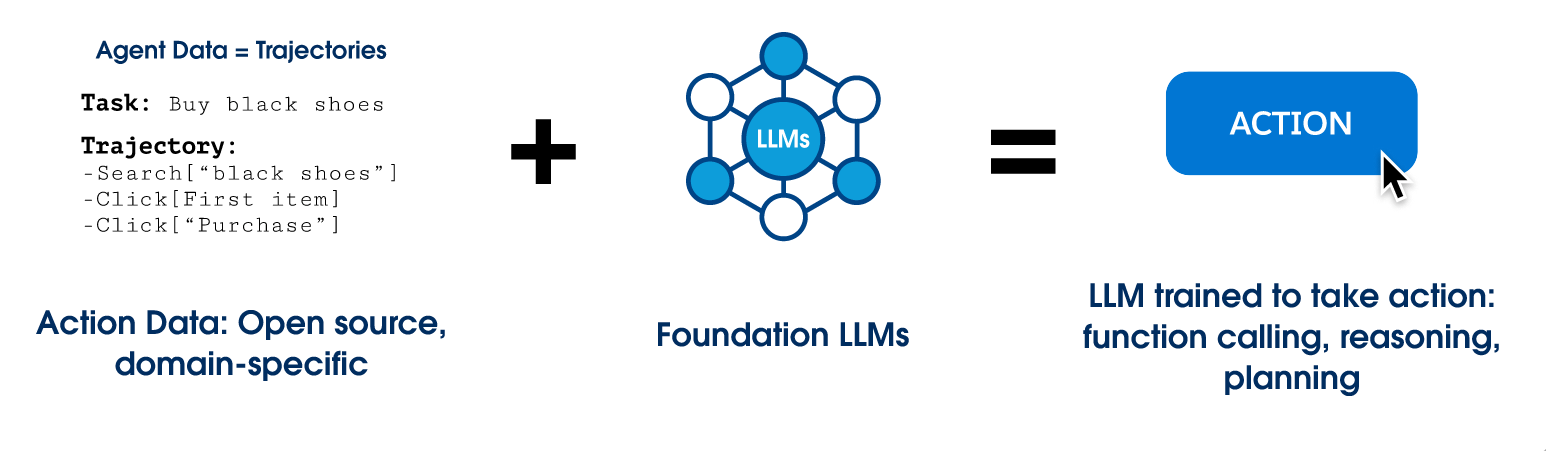

En Salesforce AI Research, estamos a la vanguardia de este emocionante desarrollo. Reconociendo el rápido ritmo de los avances en el panorama de la IA, hemos introducido xLAM, nuestra familia de modelos internos de acción de gran tamaño, diseñados para la llamada a funciones, el razonamiento y la planificación. Estos modelos están diseñados para agilizar y simplificar la integración de la IA en sus flujos de trabajo, reduciendo la complejidad a menudo asociada con los LLM. Antes de sumergirnos en la exploración de xLAM, entendamos primero los modelos de acción de gran tamaño y cómo funcionan.

Modelos de acción de gran tamaño frente a modelos de lenguaje de gran tamaño

Como muchos sabemos, los grandes modelos lingüísticos están diseñados para comprender y generar texto similar al humano. Se entrenan en amplios conjuntos de datos y pueden realizar una gran variedad de tareas relacionadas con el lenguaje. Piense en un LLM como un gran chef que elabora recetas que hacen la boca agua y ofrece instrucciones detalladas sobre cómo crear una comida gourmet.

Los modelos de acción de gran tamaño, por otro lado, están diseñados para tomar decisiones y realizar acciones en diversos entornos. Piense en un sous chef que no sólo le ayude con la receta, sino que se encargue de tareas como cocinar, picar, mezclar y asegurarse de que el plato se prepara exactamente como se necesita sin que usted mueva un solo dedo. En el ámbito de la IA, los modelos de acción lingüística (LAM) son un subconjunto especializado de los modelos de lenguaje de gran tamaño (LLM) diseñados principalmente para generar acciones, normalmente mediante llamadas a funciones. Estos modelos están causando furor en el ámbito de la gestión de las relaciones con los clientes (CRM), donde resulta crucial comprender el contexto y tomar las decisiones adecuadas en nombre de la empresa. En términos de CRM, los LAM van más allá de la mera comprensión y generación de contenidos: se encargan de la ejecución. Automatizan los flujos de trabajo, gestionan las tareas y se aseguran de que todo funcione correctamente. Si el LLM proporciona la receta, el LAM se asegura de que los ingredientes se cortan, mezclan y cocinan a la perfección, proporcionando resultados sin que usted tenga que mover un dedo.

Conozca xLAM, nuestra familia de modelos de acción de gran tamaño

xLAM, la familia de modelos de acción de gran tamaño de Salesforce AI Research se ha convertido en todo un avance en este último mes. Esta innovadora familia de modelos ha ascendido rápidamente a la cima, ocupando el puesto número 2 en las tablas de clasificación de Berkeley para Function calling V1 (fecha límite 08/12/2024), superando incluso a algunas variantes de GPT-4. La eficacia de xLAM-1B depende de la calidad superior y la variedad de sus datos de entrenamiento. El pipeline APIGen utiliza 3.673 API ejecutables que abarcan 21 categorías, cada una de ellas sometida a un exhaustivo proceso de verificación en tres pasos que incluye comprobaciones de formato, ejecuciones reales de funciones y verificación semántica para garantizar la integridad y relevancia de los datos. Profundicemos en los modelos específicos de la familia xLAM y exploremos sus capacidades y aplicaciones únicas.

Tiny (xLAM-1B)

Conocida como nuestro «Gigante diminuto», esta versión compacta de xLAM cuenta con 1B parámetros. Dado el tamaño compacto del modelo, es el más adecuado para aplicaciones en dispositivos donde los modelos más grandes resultan poco prácticos.

Pequeño (xLAM-7B)

Un modelo 7B diseñado para la exploración académica rápida con recursos de GPU limitados.

Mediano (xLAM-8x7B)

Un modelo 8x7B de mezcla de expertos, ideal para aplicaciones industriales que buscan una combinación equilibrada de latencia, consumo de recursos y rendimiento.

Grande (xLAM-8x22B)

Se trata de un modelo de mezcla de expertos grande si dispone de grandes recursos de cálculo y desea obtener el máximo rendimiento.

Large Action Models: El poder de la llamada a funciones

Como hemos mencionado anteriormente, los LAM están diseñados principalmente para generar acciones, normalmente a través de la llamada a funciones. Un claro ejemplo de ello es cómo estos modelos pueden mejorar la eficacia de los representantes de ventas. Consideremos un escenario en el que un representante de ventas necesite cancelar un pedido. En lugar de navegar por múltiples sistemas, el representante podría simplemente pedir a un copiloto de IA que se encargue de la tarea. La IA, impulsada por un LAM, entiende la solicitud, determina que el sistema de gestión de pedidos (OMS) es la aplicación pertinente y ejecuta la función necesaria para cancelar el pedido.

Nuestra serie de modelos xLAM lleva esta capacidad al siguiente nivel, especialmente optimizada para la llamada a funciones. En el Berkeley Function Calling Leaderboard V1, xLAM-7B(fc) supera a los principales modelos, incluidos GPT-4 de OpenAI y Claude-3-Opus, a pesar de ser significativamente más pequeño y rentable. En un ámbito en el que la precisión y la confianza son primordiales -dado que estas transacciones a menudo implican la actualización de datos críticos-, la serie de modelos xLAM no sólo agiliza las operaciones, sino que también garantiza que las acciones se ejecuten con precisión, mostrando el sólido potencial de los LAM en aplicaciones del mundo real.

xLAM en un mundo de múltiples agentes

Esta funcionalidad sienta las bases para sistemas de agentes autónomos robustos, marcando un avance significativo en la forma en que la IA puede agilizar y mejorar las operaciones empresariales. La potencia de xLAM no se limita a un único agente. De hecho, xLAM puede utilizarse para potenciar la toma de decisiones y las acciones de muchos agentes colaborativos. Con muchos agentes altamente especializados impulsados por xLAM, se pueden lograr tareas cada vez más complejas de forma autónoma.

Para obtener más información sobre esta dirección de vanguardia, inscríbase en nuestra sesión Dreamforce.

Conclusión

En conclusión, la evolución de los modelos de lenguaje de gran tamaño (LLM) a los modelos de acción de gran tamaño (LAM) marca un salto significativo en las capacidades de IA dentro de los sistemas CRM. La introducción de xLAM por parte de Salesforce AI Research, una familia pionera de Large Action Models, subraya este cambio hacia herramientas de IA más autónomas, eficientes y conscientes del contexto. Al gestionar flujos de trabajo complejos y procesos de toma de decisiones, xLAM no sólo mejora la eficacia operativa, sino que también redefine las interacciones de los usuarios con los sistemas CRM. A medida que continuamos explorando y ampliando los potenciales de xLAM, el futuro del CRM se presenta prometedoramente más intuitivo y automatizado, prometiendo transformar profundamente las operaciones empresariales y las relaciones con los clientes.

Explore More

Agradecimientos

Lista completa de autores: Jianguo Zhang∗, Tian Lan∗, Ming Zhu∗, Zuxin Liu∗, Thai Hoang∗, Shirley Kokane†, Weiran Yao†, Juntao Tan, Akshara Prabhakar, Zhiwei Liu, Haolin Chen, Yihao Feng,Tulika Awalgaonkar, Rithesh Murthy, Eric Hu, Zeyuan Chen, Ran Xu, Juan Carlos Niebles, Shelby Heinecke, Huan Wang, Silvio Savarese, Caiming Xiong