En nuestra serie de preguntas y respuestas «Engineering Energizers», exploramos las trayectorias de los líderes de ingeniería de Salesforce que han alcanzado logros significativos en sus campos. Hoy nos ponemos al día con Erwin Karbasi, líder del equipo de Observabilidad de aprendizaje automático (ML) de Salesforce. Su equipo es responsable de mantener la fiabilidad y el rendimiento de las aplicaciones de IA generativa durante todo su ciclo de vida

Descubra cómo el equipo de Erwin aborda las alucinaciones de los grandes modelos de lenguaje (LLM) y los problemas de generación aumentada por recuperación, proporciona información sobre el rendimiento inmediato y respalda el ciclo de vida de desarrollo de la IA generativa mediante el aprendizaje y el perfeccionamiento continuos.

¿Cuál es la misión de su equipo?

Nos centramos en implementar mecanismos sólidos de supervisión y retroalimentación que mantengan la precisión del modelo y realicen un seguimiento del rendimiento durante los ciclos de vida. La detección temprana de anomalías y la resolución rápida de los problemas son fundamentales para preservar la integridad de las soluciones de IA.

Detección temprana de anomalías y resolución rápida de los problemas

Además, analizamos las interacciones y los comentarios de los usuarios para impulsar mejoras iterativas. Esto garantiza que las aplicaciones de IA sigan siendo eficaces, adaptables y alineadas con las necesidades de los usuarios y los objetivos empresariales. A través del aprendizaje y el perfeccionamiento continuos, ayudamos a que los modelos de IA sean más inteligentes y fiables con el paso del tiempo.

¿Cuál fue el reto técnico más importante al que se enfrentó su equipo recientemente y cómo lo superó?

El equipo se encontró con un gran obstáculo a la hora de supervisar y garantizar la observabilidad de las aplicaciones de IA generativa. Para solucionarlo, se utilizó el Marco de evaluación central de Salesforce (SF Eval) para implementar y realizar un seguimiento de:

- Métricas operativas del modelo: las inferencias procesadas, junto con las advertencias y los errores, se supervisaron para mantener la salud del sistema y resolver problemas de forma proactiva.

- Métricas de generación de texto y código: la calidad del texto se evaluó mediante métricas como la puntuación de detección de toxicidad y la puntuación de detección de sesgos para garantizar que el contenido fuera seguro y preciso.

- Métricas de funcionamiento del modelo: se supervisaron las inferencias procesadas, junto con las advertencias y los errores, para mantener el estado del sistema y resolver problemas de forma proactiva

- Métricas de recuperación y generación mejorada (RAG): La coherencia y relevancia de los hechos se comprobaron con las métricas de relevancia contextual y relevancia de la respuesta.

- Métricas de latencia: Se controlaron los tiempos de respuesta para mejorar el rendimiento del sistema.

- Latency Metrics

- Métricas específicas del modelo: se realizó un seguimiento de las puntuaciones BLEU y la perplejidad para perfeccionar el rendimiento del modelo.

- Métricas de tokens y costes: los gastos y el uso de tokens se gestionaron para optimizar la eficiencia y controlar los costes.

- Métricas de precisión de las instrucciones: Se perfeccionó continuamente el diseño de prompt para mejorar el rendimiento de la IA.

- Prompt Accuracy Metrics

Por medio de la implementación de estas diversas métricas, el equipo se aseguró de que las aplicaciones de IA generativa siguieran siendo precisas, fiables y eficaces.

¿Qué retos suelen encontrar los LLM en producción?

Desplegar LLM en producción implica varios retos. Un problema significativo son las alucinaciones LLM, en las que el modelo genera información incorrecta pero la presenta como exacta. Esto puede minar la confianza del usuario y comprometer la fiabilidad de la aplicación. Para combatirlo, nuestro equipo supervisa activamente los resultados para identificar y corregir rápidamente las imprecisiones

Otro reto son los problemas con los procesos RAG, en los que identificar el origen de los errores de recuperación es crucial para una resolución eficaz. Nuestras herramientas de observación son fundamentales para detectar estos errores, lo que permite realizar correcciones específicas. Además, garantizar la calidad de los avisos y las plantillas de avisos es vital para mantener unos resultados de alta calidad. Nuestro equipo analiza el rendimiento de los avisos para mejorar su coherencia y fiabilidad. Este nivel de observabilidad proporciona información detallada sobre el rendimiento en las distintas capas, lo que simplifica el proceso de seguimiento y resolución de fallos

¿Cómo apoya su equipo el ciclo de vida de desarrollo de la IA generativa?

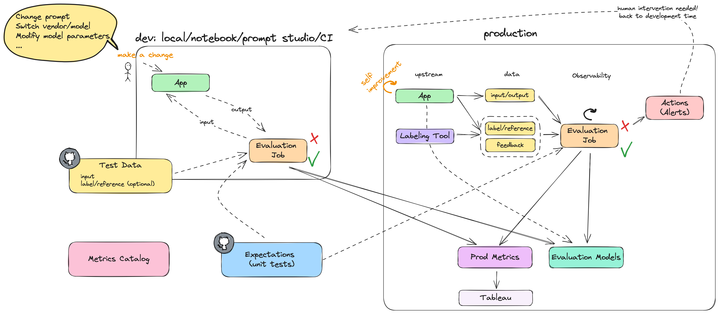

Nuestro equipo proporciona un marco integral para supervisar el ciclo de vida de las aplicaciones de IA generativa, que abarca desde su desarrollo hasta su despliegue y fases posteriores. Abordamos diversos retos, como la preservación de la precisión, la gestión de la variabilidad de los datos y el mantenimiento de normas éticas.

Al integrar sistemas avanzados de supervisión, mecanismos de retroalimentación y procesos de aprendizaje continuo, capacitamos a los desarrolladores para perfeccionar los modelos de IA de forma eficaz. Esto permite resolver rápidamente los problemas de rendimiento y adaptarse a la evolución de las tendencias de los datos. Nuestro enfoque holístico mejora la fiabilidad y la eficiencia de las aplicaciones de IA, fomentando mejoras continuas que conducen a soluciones de IA progresivamente más inteligentes y eficaces.

Preparación de la inteligencia artificial

Salesforce ML Observability ofrece un marco sólido para gestionar el ciclo de vida de las aplicaciones de IA generativa.

Salesforce ML Observability ofrece un marco sólido para gestionar el ciclo de vida de las aplicaciones de IA generativa

¿Qué pasos sigue su equipo en la fase previa a la implementación del ciclo de vida de desarrollo de la IA generativa?

Salesforce ML Observability ofrece un marco sólido para gestionar el ciclo de vida de las aplicaciones de IA generativa

En la fase previa al despliegue del ciclo de vida de desarrollo de la IA generativa, el equipo sigue un enfoque estructurado para garantizar la eficacia y la seguridad de las aplicaciones de IA:

- Ingeniería de avisos: El marco SF Eval se utiliza para refinar y probar los avisos, garantizando la eficacia y la coherencia en diferentes contextos.

- Selección y ajuste de modelos:

- Benchmarking y normas éticas: se establecen métricas de rendimiento de referencia y se aplican controles de seguridad y éticos para evitar resultados perjudiciales o sesgados. Estas salvaguardas se actualizan continuamente para reflejar la evolución de las normas.

¿Qué pasos sigue tu equipo en la fase posterior al despliegue del ciclo de vida de desarrollo de IA generativa?

Una vez desplegada una aplicación de IA generativa, nuestra atención se centra en la supervisión, el análisis y la mejora continua. Hacemos un seguimiento de los indicadores clave de rendimiento, como la precisión de las respuestas y la satisfacción de los usuarios, y optimizamos el uso de los recursos mediante alertas automatizadas que facilitan la resolución rápida de los problemas.

La recopilación de comentarios es crucial, ya que abarca las respuestas explícitas e implícitas de los usuarios. Utilizamos herramientas de análisis avanzadas para analizar estos datos, identificar tendencias, detectar anomalías y vincular el rendimiento de la IA con los resultados empresariales. Cuando surgen problemas, el análisis de la causa raíz señala sus orígenes. Empleamos pruebas A/B para perfeccionar la aplicación sin interrumpir la experiencia del usuario.

El aprendizaje continuo forma parte integral de nuestro proceso, ya que permite que el modelo se adapte a los nuevos datos y a las necesidades cambiantes. La información obtenida de la producción se retroalimenta en el desarrollo, mejorando el diseño rápido, actualizando los conjuntos de datos de entrenamiento y pasando a modelos más sofisticados cuando es necesario

¿Cómo garantiza su equipo la mejora continua y la eficacia de los informes?

Nuestro enfoque de la elaboración de informes para las partes interesadas implica la creación de informes personalizados que atiendan a las necesidades únicas de las diferentes audiencias, garantizando que todos, desde los equipos técnicos hasta los ejecutivos, reciban métricas de rendimiento de IA claras y relevantes. Integramos las actividades previas y posteriores al despliegue, fomentando un ciclo de mejora continua que mejora el rendimiento y el valor de las aplicaciones de IA generativa a lo largo del tiempo.

La IA generativa es una herramienta que permite a las empresas mejorar su rendimiento y su valor

Al adherirse a este exhaustivo marco de observabilidad, Salesforce garantiza que sus aplicaciones de IA generativa no sólo mantienen su rendimiento, sino que también evolucionan, haciéndose cada vez más inteligentes y eficaces a la hora de satisfacer las demandas empresariales.

La mejora continua de las aplicaciones de IA generativa permite a Salesforce mejorar el rendimiento y el valor de las mismas a lo largo del tiempo

¿Qué esfuerzos de investigación y desarrollo se están llevando a cabo para mejorar las capacidades de supervisión y observabilidad?

Estamos desarrollando API avanzadas para usuarios expertos en tecnología, que facilitan la integración de los datos de monitorización en los sistemas existentes para alertas automatizadas y cuadros de mando personalizados. Para los usuarios no técnicos, estamos elaborando interfaces fáciles de usar como Einstein 1 Studio, que ofrece una experiencia de bajo código o sin código, lo que hace que la monitorización sea accesible para los analistas de negocio, los gestores de proyectos y otro personal no técnico.

Estamos desarrollando API avanzadas para usuarios expertos en tecnología, lo que facilita la integración de los datos de monitorización en los sistemas existentes para alertas automáticas y cuadros de mando personalizados

Nuestro enfoque dual garantiza que todo el mundo, independientemente de sus conocimientos técnicos, pueda supervisar y mejorar eficazmente las aplicaciones de IA. Integramos estas herramientas de supervisión en todo el ciclo de desarrollo y despliegue de la IA, lo que permite la evaluación comparativa, las pruebas y la puesta a punto de los modelos tanto antes como después del lanzamiento. Esta integración fomenta un bucle de retroalimentación continua, en el que los datos de producción impulsan los ajustes de desarrollo, mejorando la inteligencia y la fiabilidad de las aplicaciones de IA. A través de estas iniciativas, pretendemos ofrecer aplicaciones de IA más inteligentes y fiables para todos los usuarios.

Más información

- ¿Cuál es el futuro de las pruebas de IA? Eche un vistazo al marco de próxima generación de Salesforce para el rendimiento de modelos de IA en este blog.

- Manténgase conectado: únase a nuestra Comunidad de talento

- Consulta nuestros equipos de Tecnología y Producto para saber cómo puedes participar.