Esta es una traducción que desde EGA Futura ofrecemos como cortesía a toda la Ohana y comunidad de programadores , consultores , administradores y arquitectos de Salesforce para toda Iberoamérica .

El enlace a la publicación original, lo encontrarás al final de este artículo.

…

Cuando nuestros socios tienen éxito, tenemos éxito. Como socio de confianza, tiene la oportunidad de desbloquear los activos de ventas, la propiedad intelectual, las mejores prácticas, las historias de los clientes, el asesoramiento personalizado y nuestra metodología de lanzamiento de Salesforce. Esto es todo lo que brindamos a nuestros equipos de ventas internos de Salesforce, entregado en un formato interactivo y atractivo.

“Nuestros socios juegan un papel fundamental para ayudar a nuestros clientes a escalar capacidades, innovar y tener éxito con Salesforce”, dice Steve Corfield, vicepresidente ejecutivo de alianzas globales, canales y productos emergentes de Salesforce.

Comience a aprender con Partner Learning Camp

Explore el principal destino de aprendizaje y amplíe sus capacidades técnicas y de ventas para satisfacer las necesidades de los clientes ahora y en el futuro.

Aumentar la oportunidad de servicios para socios

Salesforce realizó algunos cambios importantes este año para optimizar las soluciones de lanzamiento al mercado. El primer gran cambio es la tecnología y la innovación de productos. Atrás quedaron los días de almacenamiento en silos en la nube y la venta de miles de SKU. Ahora estamos vendiendo conjuntos de productos que están diseñados para satisfacer las necesidades de audiencias específicas. El enfoque en las personas de la audiencia nos permite producir ofertas más integradas y brindarles a los clientes oportunidades para desbloquear el Salesforce Customer 360 completo.

Ahora, es más fácil que nunca vender a través de Customer 360. Eso significa mayores ingresos y menor pérdida de clientes para los socios. Hay un efecto multiplicador significativo cuando un cliente tiene más de una nube. A medida que aumenta su participación en Salesforce, también puede ver una marcada disminución en el desgaste.

Los socios son clave para el éxito del cliente. Cuando nuestros socios participan estratégicamente en el ciclo de ventas:

- Las tasas de ganancias son 36 veces más altas

- El precio de venta promedio se incrementa 2x

- Los socios implementan en promedio 4,5 veces los ingresos por licencias a través de sus servicios con nuestros clientes

“Los socios que brindan valor, innovación y crecimiento más rápido desbloquean el tipo de confianza de nuestros clientes que conduce a relaciones más profundas”, dice Corfield.

Obtenga artículos seleccionados solo para usted, en su bandeja de entrada

Haga crecer sus capacidades de ventas de Salesforce para impulsar su éxito

El verdadero éxito de ventas no se trata solo de cumplir con las cuotas o realizar transacciones rápidas. Se trata de construir relaciones sólidas y duraderas con los clientes. Esto significa comprender sus necesidades únicas y brindar soluciones personalizadas que agreguen valor y resuelvan los desafíos comerciales.

Salesforce tiene una gran cantidad de recursos para ayudarlo sin importar su rol de vendedor. Elija entre seminarios web interactivos breves y cursos a pedido en Partner Learning Camp (PLC). Disponibles para todos los socios de Salesforce, estos recursos están diseñados para ayudarlo a impulsar el éxito de las ventas a lo largo del ciclo de vida del cliente.

Generación de demanda: aprenda el valor de Salesforce y obtenga información sobre compradores únicos con los seminarios web Sales Messaging 101 . Luego, amplíe sus conocimientos en el seminario web Creación de proyectos y calificación de clientes potenciales . Aprenderá cómo comprender los puntos débiles de su cliente, involucrar a sus tomadores de decisiones y hacer avanzar la oportunidad.

Progresión del trato: una vez que tenga una cartera saludable de clientes potenciales, es hora de sobresalir en el lanzamiento. Sales Kickstart ofrece una clase magistral completa para ayudarlo a perfeccionar su presentación. Durante tres medios días, Kickstart ofrece capacitación personalizada para dar forma a su marco de presentación, ayudarlo a contar historias de clientes y vender en Customer 360. Esta capacitación también está disponible a pedido en PLC.

Entrada al mercado repetible: las personas que demuestren liderazgo en ventas en el ecosistema de socios pueden ser invitadas a convertirse en campeones de ventas de Salesforce . Es una oportunidad para obtener acceso a asesoramiento personalizado, preparación de lanzamientos y comentarios. En su tercer año, Salesforce ha ayudado a su grupo élite de campeones a obtener millones de dólares en proyectos. Los campeones guían a los clientes sobre las opciones tecnológicas correctas para el éxito y los ayudan a superar los desafíos comerciales y del mercado.

Reciba recompensas por enviar clientes potenciales

Cierre tratos más rápido y a una tasa más alta, desbloquee los beneficios de los socios, gane tarifas de referencia y desarrolle una asociación sólida con Salesforce.

Complemente sus capacidades con recursos técnicos y de marketing

Amplíe el impacto de sus capacidades de ventas de Salesforce aprovechando los siguientes recursos. Al hacerlo, desarrollará sus capacidades técnicas, accederá a recursos de marketing y capacitación, y aprenderá cómo llegar a sus clientes en el momento y lugar correctos.

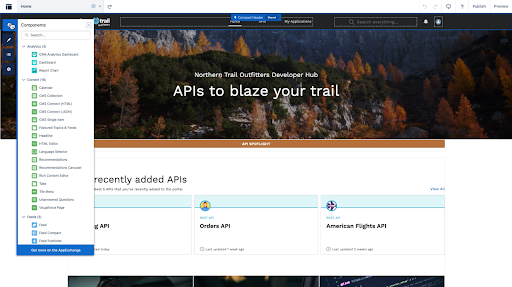

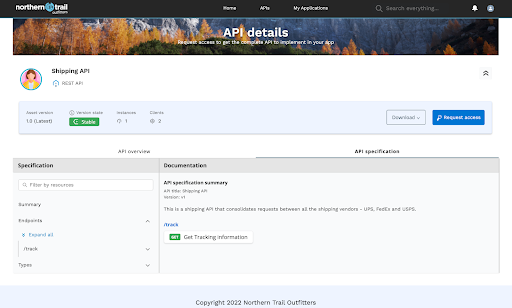

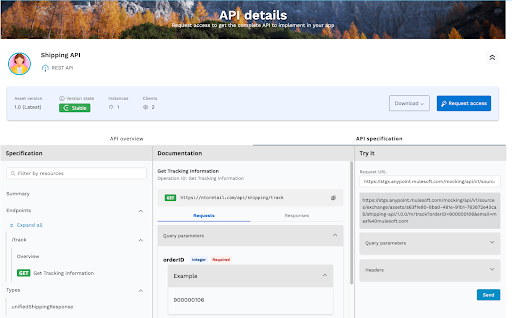

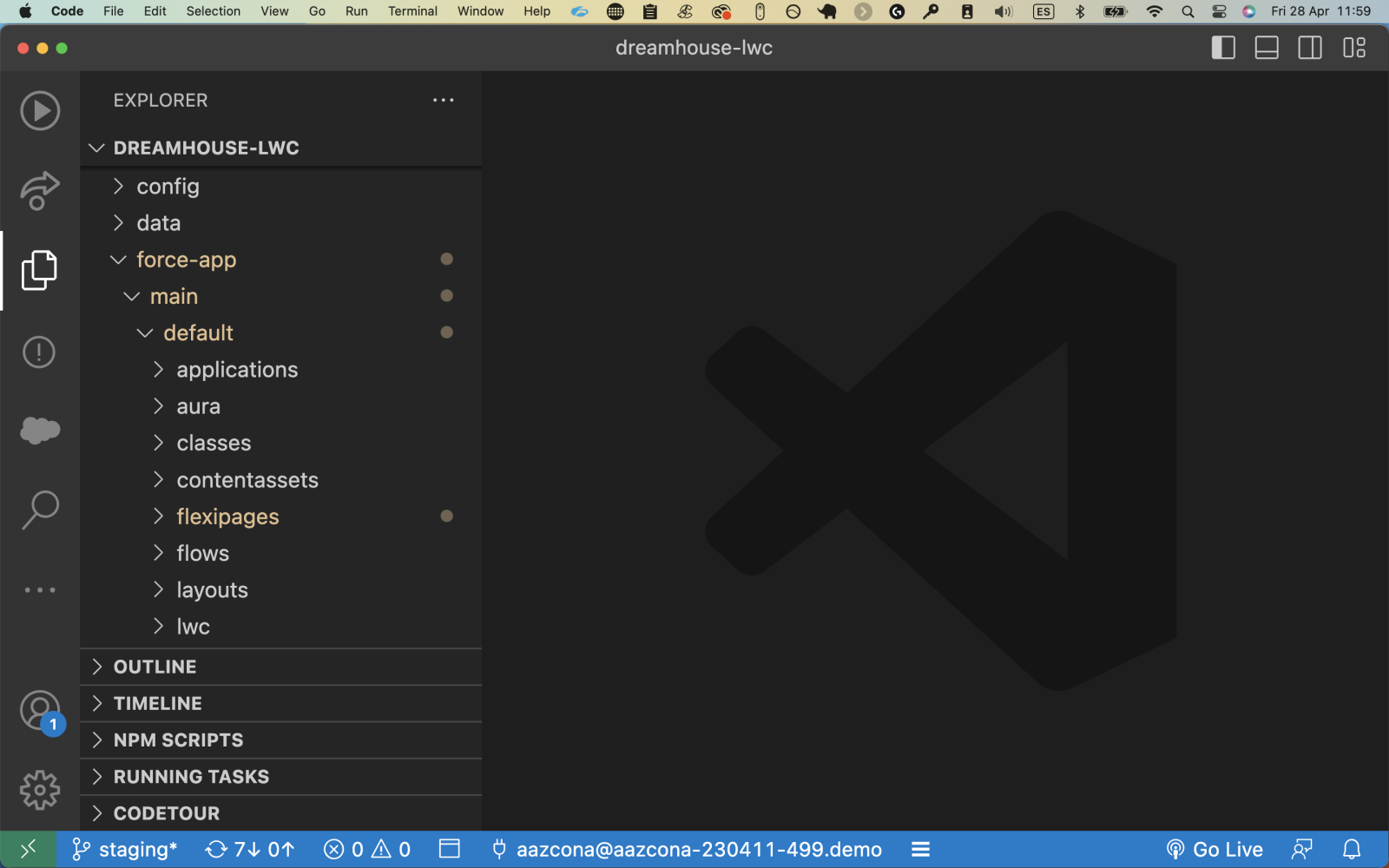

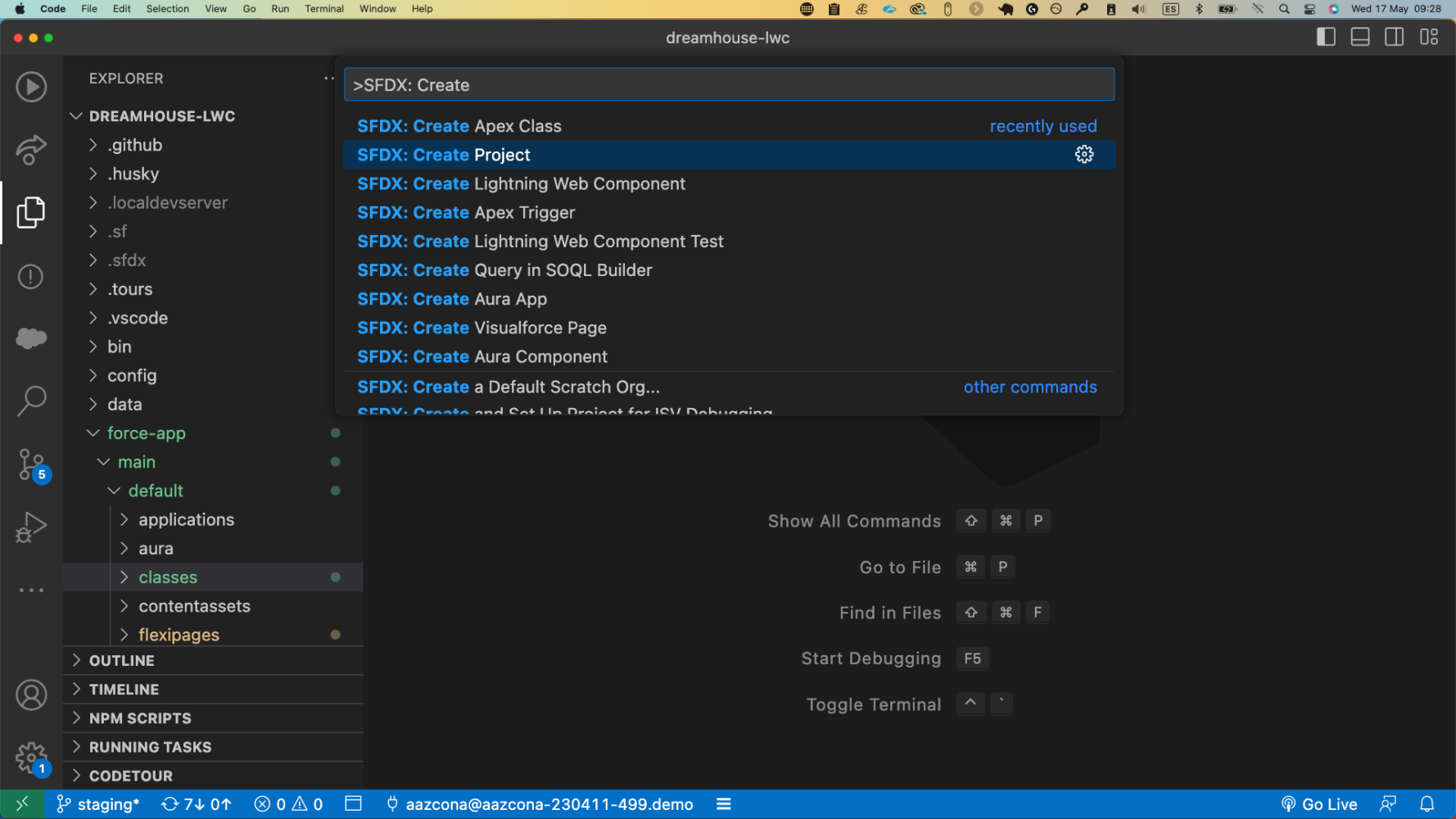

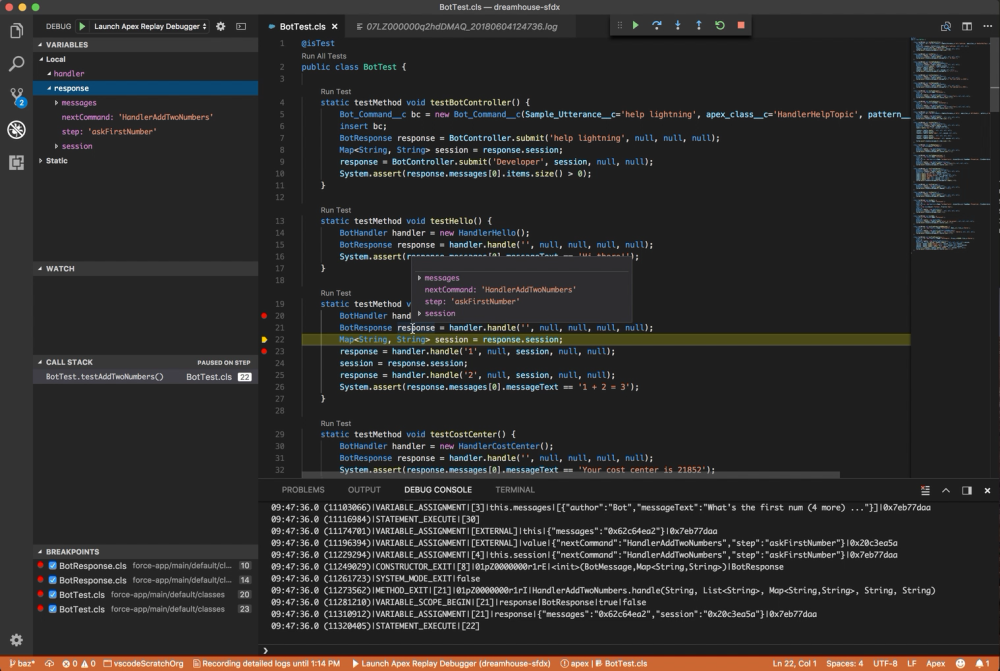

Desarrolle experiencia técnica: acceda a cursos y planes de estudios para mejorar sus capacidades técnicas . Sumérjase en la capacitación disponible a través de Trailhead, Trailhead Academy, credenciales de Salesforce y Partner Learning Camp. Acceda a cursos específicos de funciones, como talleres impartidos por ingenieros de soluciones, para ingenieros de soluciones.

Llegue a sus clientes en el momento y el lugar correctos: el Centro de marketing para socios es una biblioteca de materiales gratuitos de marketing y ventas para ayudarlo a impulsar la demanda. Acceda a contenido gratuito, preconstruido y personalizable basado en la personalidad del comprador. Encontrará recursos como libros de jugadas de campaña, copia de correo electrónico, mazos de ventas, guiones de llamadas y más.

El programa de marketing de AppExchange puede ayudarlo a generar demanda, impulsar el éxito de los clientes y mejorar la visibilidad. Además, obtendrá oportunidades de marketing conjunto llave en mano con Salesforce.

Accelerate Grow puede ofrecerle más entrenamiento práctico. Este programa acelerador virtual de 9 semanas puede ayudarlo a salir al mercado más rápido y escalar el éxito de su empresa. Tendrá acceso a revisiones de listados personalizados, sesiones interactivas dirigidas por expertos y aprendizajes a pedido.

Amplíe sus operaciones de reventa: los revendedores pueden obtener una vista tras bambalinas sobre pronósticos, informes y el lado operativo de la gestión del negocio. Esto está disponible como un Bootcamp de reventa (que incluye Sales Kickstart) o como un taller de operaciones de reventa independiente.

Como socio de Salesforce, su excelencia en ventas impulsa la excelencia de la empresa. Puede maximizar el valor de su asociación desbloqueando un mundo de recursos para impulsar el éxito de ventas, expandir su base de clientes y prosperar en un mercado competitivo.

Salesforce está abriendo camino hacia los 50.000 millones de dólares en ingresos para 2026. Somos la empresa de software empresarial de más rápido crecimiento entre las cinco principales, y nuestros socios son fundamentales para ese crecimiento. Extienden la funcionalidad de la plataforma con aplicaciones personalizadas y ayudan a los clientes a implementar la tecnología. Junto con nuestros socios, crecemos, innovamos e invertimos en formas que ayudan a los clientes a transformar sus negocios.

Seguir leyendo